Catégorie : Technologies

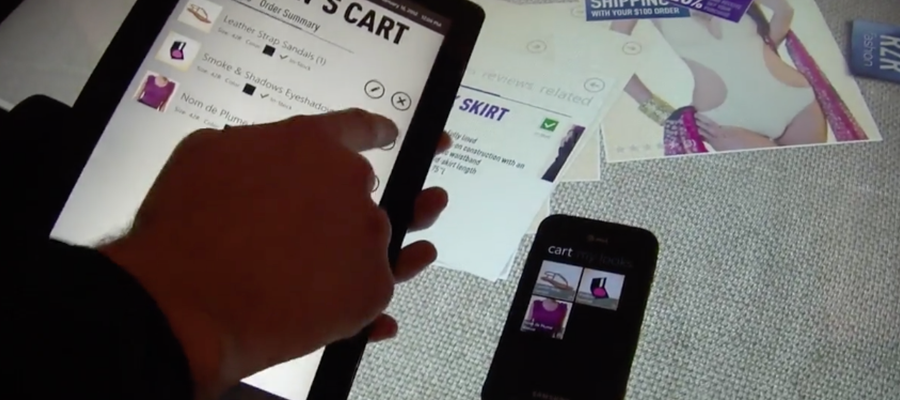

Comment réinventer l’expérience utilisateur dans les processus d’achat ?

Beaucoup d’acteurs cherchent une solution à l’utilisation des magasins comme simples showrooms par le client, lequel achète ensuite moins cher sur Internet. Des expériences émergentes tendent à repenser l’expérience utilisateur en magasin. […]

La photo numérique et ses avatars computationnels, le déplacement du moment artistique

L’été est propice à la multiplication des prises de vues, mais à observer les usages du plus grand nombre, la photo numérique est encore le plus souvent perçue comme une nouvelle façon de faire les mêmes photos qu’avant, en plus grand nombre, avec une possibilité de résultat et de choix instantanés et à coût quasi-nul. Mais ce qui fait que la photo numérique s’éloigne de plus en plus de l’argentique, c’est le traitement computationnel de l’image […]

HDR, La photo numérique entre hyperréalisme et ultraréalisme

La photo numérique se différencie de plus en plus de l’argentique. Le codage et le calcul qui remplacent la trace physico-chimique ouvrent la voie à une infinité de manipulations de l’image et à l’hybridation,

Honni soit qui mal y pense. La tentation Free malmène Bouygues, Orange et SFR.

Google Tendances révèle l’impact premier de l’arrivée de Free sur le mobile. Le jour même de la conférence très cash de Niel, les requêtes « résiliation » sur Google sont multipliées par un facteur d’ordre dix

Kindle, Kobo, Cybook et les autres. Les liseuses numériques, outils d’une mutation

Fin d’un monde ou nouveau monde ? Mutation ou révolution ? La liseuse de Fragonard pourrait-elle bientôt apparaître comme un témoin d’un mode de lecture révolu ? C’est un fait annoncé, avec l’arrivée en France du poids

Steve Jobs est mort. Comment son imaginaire technologique nous a rencontré au travers d’Apple.

Quand j’ai acheté mon iPhone, puis mon ipad, je ne savais pas que j’en avais besoin…Cela pourrait être une explication de ce qui vaut à Steve Jobs, fondateur d’Apple, un hommage quasi unanime pour son apport dans l’industrie du numérique […]

Facebook révolution, ou domestication ? deux visages des réseaux sociaux

Zoom sur 2 différentes approches des usages des réseaux sociaux a priori sans rapports directs mais qui, placées l’une en regard de l’autre, illustrent bien leur ambivalence… […]